《DeepSeek》本地部署攻略:全新升级,轻松上手!

想要在本地部署DeepSeek模型吗?别担心,本文将为你提供一份详尽的攻略,让你轻松上手!

一、准备工作

你需要确保你的电脑满足以下要求:

操作系统Linux(推荐Ubuntu 20.04或更高版本)或Windows。

Python3.8或更高版本。

GPU支持CUDA的NVIDIA GPU(推荐16GB显存以上)。

CUDA11.2或更高版本。

CUDNN8.1或更高版本。

二、安装Ollama

Ollama是一个开源的大型语言模型服务工具,它可以帮助你快速在本地运行大模型,简化了在Docker容器内部署和管理大语言模型(LLM)的过程,你可以根据自己的操作系统选择对应的安装包,然后安装Ollama软件。

Linux系统部署可以使用一键安装脚本,或者通过包管理器安装,安装完成后,需要进行权限配置和启动服务。

macOS系统部署同样可以使用一键安装脚本,或者通过Homebrew进行安装,安装完成后,可以直接启动服务。

Windows系统部署需要下载安装包,并进行双击安装,安装完成后,需要验证安装是否成功。

三、部署DeepSeek

在Ollama官网搜索DeepSeek大模型,并根据自己电脑配置选择大模型版本,你可以使用Ollama的命令行工具来拉取并运行DeepSeek模型。

拉取模型使用ollama pull命令来拉取你选择的DeepSeek模型版本。

运行模型使用ollama run命令来运行拉取到的DeepSeek模型。

四、使用DeepSeek

你可以直接在命令行中与DeepSeek模型进行交互,或者通过前端工具(如ChatBox)来更方便地与模型进行交流。

命令行交互在命令行中输入你的问题或指令,模型会立即给出回答或执行结果。

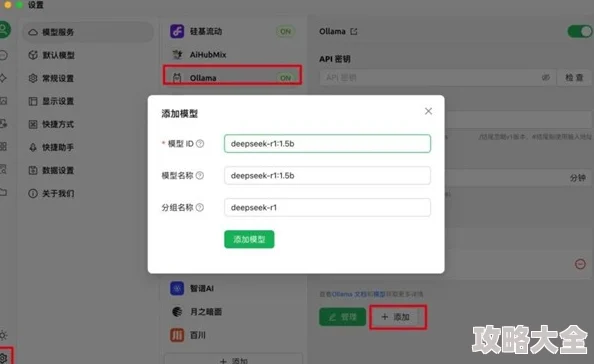

ChatBox客户端ChatBox是一个跨平台的前端工具,它支持对接各种大模型(包括DeepSeek),你可以下载并安装ChatBox,然后配置DeepSeek模型到ChatBox中,就可以通过ChatBox与模型进行交互了。

五、性能优化与故障排查

为了确保DeepSeek模型在本地运行时的性能和稳定性,你可以进行一些性能优化操作,并学会如何进行故障排查。

性能优化根据你的硬件资源选择运行模式(如纯CPU运行、CPU+GPU混合运行等),并限制线程数、使用量化模型等优化措施来减少资源占用和提高性能。

故障排查如果模型无法启动或加载失败,你可以查看日志文件、检查端口冲突、重新初始化模型等操作来排查和解决问题。

六、本地部署的优势

与在线工具相比,本地部署DeepSeek模型具有以下优势:

隐私性高数据都在本地处理,不用担心泄露问题。

稳定性强不受网络影响,只要电脑不坏就能稳定运行。

可定制性强可以根据自己的需求进行调整和优化。

本地部署也有一些不足之处,如硬件要求高、部署复杂、维护成本高等,但是只要你按照本文的攻略来操作,相信你一定能够轻松上手并享受本地部署带来的便利和优势!

转载请注明出处:小哥壹站游戏网,如有疑问,请联系(9986784)。

本文地址:https://www.xgyz.net/yxdt/2374.html